Robots emocionales: la empatía de las máquinas

Guillermo Cárdenas Guzmán

Shutterstock

Científicos e ingenieros desarrollan una nueva generación de autómatas capaces no sólo de entender nuestro lenguaje natural, sino de interpretar y expresar estados anímicos. ¿Podremos algún día reír y llorar con ellos?

En su famosa novela ¿Sueñan los androides con ovejas eléctricas? el escritor de ciencia ficción Philip K. Dick describe a unos asombrosos autómatas llamados Nexus 6 que en su comportamiento, apariencia e inteligencia son casi idénticos a los seres humanos. La obra ha sido adaptada para dar forma a dos películas tituladas Blade Runner. La original salió en 1982 y su secuela, Blade Runner 2049, se estrenó el año pasado.

Además de tener mayor fuerza y agilidad, los androides —que en la pantalla grande se llaman “replicantes”— pueden imitar nuestras habilidades físicas e intelectuales como el movimiento o el habla, pero son incapaces de expresar emociones. Esta limitante da la pauta al protagonista de la novela, Rick Deckart, para distinguir de los humanos a este linaje de androides —que se han convertido en una amenaza para la Tierra—. Una prueba psicológica que mide la empatía le facilita esta tarea, pues los Nexus 6 no tienen sentimientos y se muestran indiferentes al gozo o sufrimiento de los seres vivos.

Los robots que Philip K. Dick imaginó en 1968 siguen siendo un desafío para los expertos en robótica. Como lo resumió el pionero en inteligencia artificial Marvin Minsky en su libro Society of Mind, las emociones son tan esenciales, que en vez de plantear si un robot podría tenerlas, más bien debemos preguntarnos si una máquina carente de ellas sería realmente inteligente.

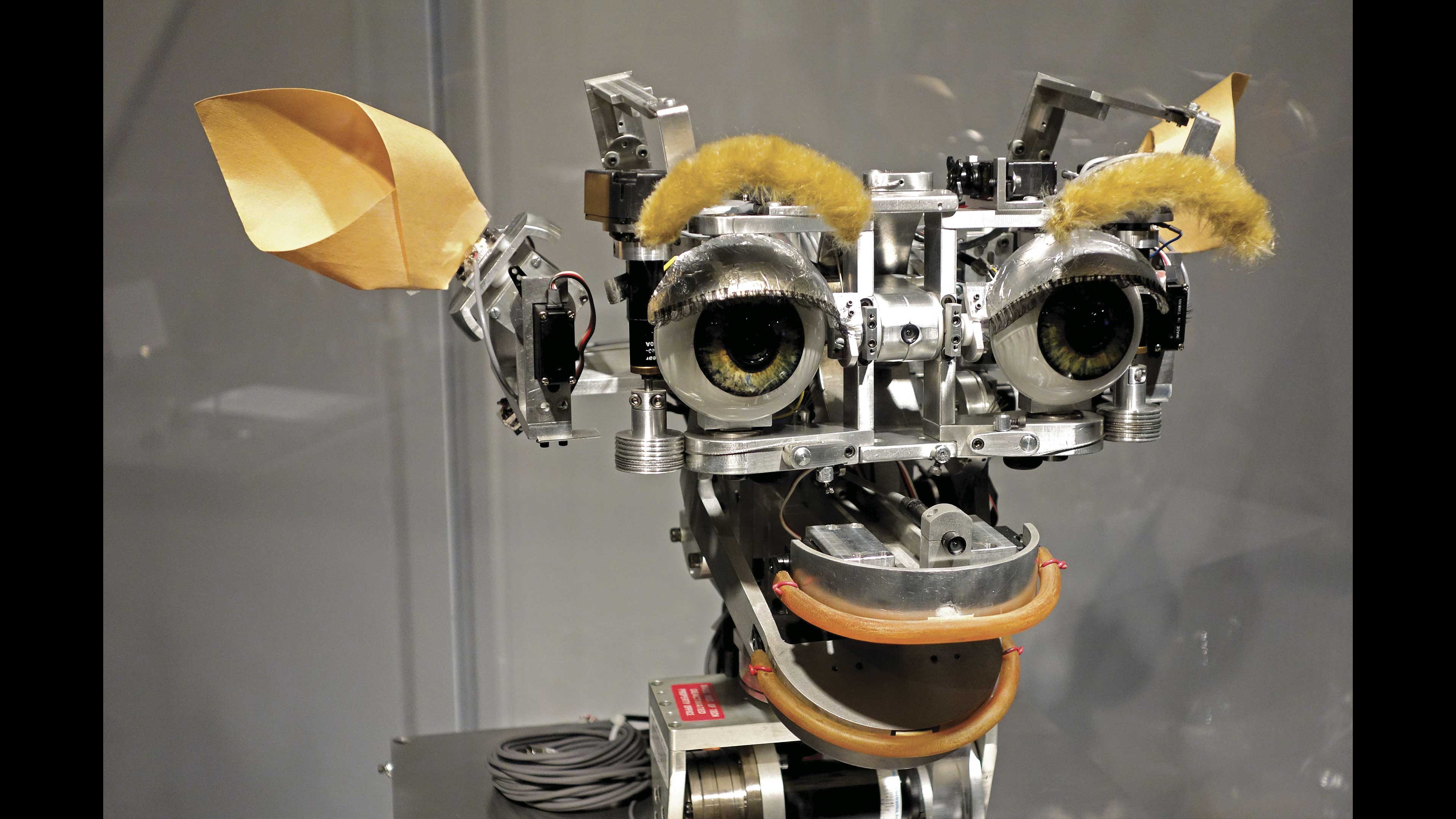

Kismet (foto: Daderot).

Kismet (foto: Daderot).

De las cosas a las personas

Gracias a las nuevas tecnologías de cómputo los robots industriales están presentes en todas partes: líneas de ensamble de autos, quirófanos, y hasta en otros planetas, como el vehículo Curiosity, que desde 2012 recoge y analiza muestras del suelo marciano (véase ¿Cómo ves? No. 178). En cambio los robots con habilidades sociales y comunicativas son escasos. Si bien en países avanzados como Japón y Estados Unidos ya se fabrican algunos modelos capaces de interactuar con los humanos, como Kismet y Jibo, aún estamos lejos de tener Arturitos (como en La guerra de las galaxias) o robotinas (como en Los supersónicos) que nos escuchen y asistan en la escuela, el hogar o los hospitales.

Como escribió la investigadora Cynthia Breazel, del Laboratorio de Inteligencia Artificial del Instituto Tecnológico de Massachusetts (MIT), “la robótica se ha ocupado más de la interacción con las cosas que con las personas”. Pero las cosas han empezado a cambiar en las últimas décadas. Conscientes de que los robots industriales son “máquinas ciegas” que actúan en forma repetitiva conforme a programas específicos, como afirma Humberto Sossa Azuela, del Centro de Investigación en Computación del Instituto Politécnico Nacional (CIC), muchos expertos buscan romper ese paradigma. El desafío es grande, pues un autómata con las características definidas por Minsky debería identificar patrones en forma óptima, usar lo que llamamos sentido común y experimentar emociones que lo lleven a tomar decisiones, resume Sossa, jefe del Laboratorio de Robótica y Mecatrónica del CIC. Jesús Savage Carmona, titular del Laboratorio de BioRobótica de la Facultad de Ingeniería de la UNAM, plantea por su parte que un robot con estas características debe tener sistemas que le permitan reconocer expresiones faciales, voces y entonaciones, además de responder de acuerdo con los estados de ánimo de su interlocutor. “Debe ser capaz de identificar no sólo lo que dice una persona, sino su estado de ánimo”.

Eduardo Bayro Corrochano, quien junto con su equipo del Centro de Investigación y Estudios Avanzados (Cinvestav) Unidad Guadalajara desarrolla robots humanoides, explica que en primer lugar estas máquinas deben ser suficientemente robustas en sus componentes electromecánicos para alojar programas de reconocimiento o aprendizaje. El siguiente paso es diseñar circuitos específicos para reproducir los procesos mediante los cuales un individuo incorpora información de su medio y adquiere conocimientos. Estos circuitos pueden basarse en la fisiología del sistema nervioso humano.

De la razón a la emoción

Para Humberto Sossa uno de los mayores obstáculos para producir robots con emociones es que éstos deben tener capacidades similares a las del cerebro humano.

El enfoque tradicional para la fabricación de robots, llamado de arriba hacia abajo, está basado en seguir reglas de operación que les permiten a las máquinas resolver cierto tipo de problemas complejos que la mente humana no podría procesar. El ejemplo típico es la computadora Deep Blue de la compañía IBM, que en 1997 derrotó al campeón mundial de ajedrez Gary Kasparov. Esta máquina podía analizar hasta 200 millones de posiciones del tablero por segundo y anticipar la próxima jugada de su rival humano. Si clasificamos su desempeño lógico, Deep Blue resulta un prodigio. Su “fuerza bruta” residía en su capacidad de cálculo; sin embargo, su nivel de inteligencia emocional (si extrapolamos la definición del psicólogo Daniel Goleman a la robótica) sería nulo.

Para superar esta limitante, Sossa Azuela propone usar otro enfoque para el diseño y construcción de máquinas inteligentes: el de abajo hacia arriba, basado ya no sólo en el seguimiento de algoritmos o fórmulas, sino en el aprendizaje. “Tenemos que proponer nuevos modelos de redes neuronales que se aproximen más al funcionamiento de las neuronas humanas, que operan en forma colaborativa”.

Carlos Gershenson, del Instituto de Investigaciones en Matemáticas Aplicadas y Sistemas (IIMAS) de la UNAM, señala que la idea de construir una máquina capaz de aprender en lugar de programar todo su comportamiento desde el principio ya había sido perfilada por otro pionero de la computación: el científico británico Alan Turing (véase ¿Cómo ves? No. 163). El gran reto es que una con capacidad emocional respondería de maneras distintas a los mismos datos de entrada, según sus emociones, mientras que una máquina sin esa capacidad da siempre la misma respuesta a una misma entrada. El científico del IIMAS lo resume con un ejemplo cotidiano: los humanos reaccionamos de distinta forma ante una situación si estamos contentos, tristes o enojados.

Esto puede lograrse, según Gershenson, diseñando programas que imiten dichas funciones reguladoras de las emociones, aunque no necesariamente con los mismos mecanismos que usa el cerebro humano para procesarlas.

Conexión profunda

En su tesis de maestría, titulada “Entrenamiento de un robot Nao para la enseñanza de conceptos básicos a niños”, Diana Uriel, egresada del Centro de Investigación en Computación del IPN, se dio cuenta de lo importante que es la conexión emocional entre humanos y androides. Dirigida por Humberto Sossa, Uriel evaluó la utilidad del Nao, robot comercial de forma humanoide fabricado por Aldebaran Robotics, en la enseñanza de colores y figuras geométricas a un grupo de cuatro niños de entre dos y cuatro años. Uriel empleó técnicas de reconocimiento de patrones y análisis de imagen para programar al robot.

Aunque el Nao no tiene expresiones faciales, los menores interactuaron muy bien con él y lo trataron como a un compañero de juegos. Sin embargo, se enfadaron porque no los reconocía por sus nombres, según recuerda Humberto Sossa. Diana Uriel tuvo que generar unas líneas de código de programación para que el robot saludara en forma personalizada a los menores que fueron evaluados. “Aunque en realidad el robot no los reconoció, a los niños les dio mucho gusto oír su nombre y de inmediato establecieron una conexión emocional con él”, refiere Sossa Azuela.

Con este trabajo descubrieron que algunos menores renuentes a interactuar con la gente podían socializar fácilmente con el robot. Por ello, los científicos del CIC buscarán mejorarlo para que ayude a detectar tempranamente casos de autismo, ceguera o daltonismo, además de apoyar los procesos de enseñanza o rehabilitación.

Cibernética geométrica

Desde 2010 Eduardo Bayro y sus colegas fabricaron un pequeño humanoide de 110 centímetros de alto al que llamaron Mex One. Para que pudiera percibir objetos y librar obstáculos, lo equiparon con un sistema de procesamiento de imágenes estereoscópicas similar al que emplea el dispositivo Kinnect, que se conecta a las cajas de videojuegos X Box para reconocer movimientos. También le instalaron un sensor tridimensional con el cual el robot (que tiene 25 grados de libertad de movimiento equivalentes al número de movimientos independientes) puede explorar ambientes en un rango que va desde los 50 centímetros hasta los 15 metros a su alrededor.

La meta de los expertos del Cinvestav Guadalajara fue producir un robot social de asistencia, pero de muy bajo costo, pues sólo invirtieron 50 000 dólares en su desarrollo, mientras modelos comerciales disponibles en el mercado —como el Asimo de Honda— pueden superar el millón de dólares. Para lograr esto, Bayro ha aplicado el conocimiento de varias ramas de la cibernética y la robótica, como el aprendizaje profundo (que permite a los robots reconocer objetos y ubicaciones físicas), las arquitecturas cognitivas y los métodos geométricos.

Con la cibernética geométrica, explica en entrevista, es posible formular los complejos algoritmos que rigen el comportamiento de un robot social —lo que requiere cálculos matemáticos en 30 o hasta 40 dimensiones— utilizando pocos parámetros y sin redundancias, es decir, resolver los problemas en forma más eficaz y económica. “Como la teoría y las matemáticas en que se basan los algoritmos no cuestan, los incorporo en el hardware. Esto genera un efecto de alto impacto, pues la máquina inteligente opera con métodos geométricos muy avanzados y a bajo costo”, señala el científico del Cinvestav.

El equipo de Bayro está convencido que con estas herramientas podrán fabricar en el futuro cercano robots sociales cada vez más sofisticados, capaces de “entender” conceptos abstractos y estados de ánimo.

Por lo pronto, él y su equipo ya trabajan en el diseño de un nuevo robot social llamado Cinvesrob. El hardware ya está casi listo, pero continúan afinando el software usando los métodos geométricos para que el autómata sea capaz de percibir estímulos y reconocer objetos.

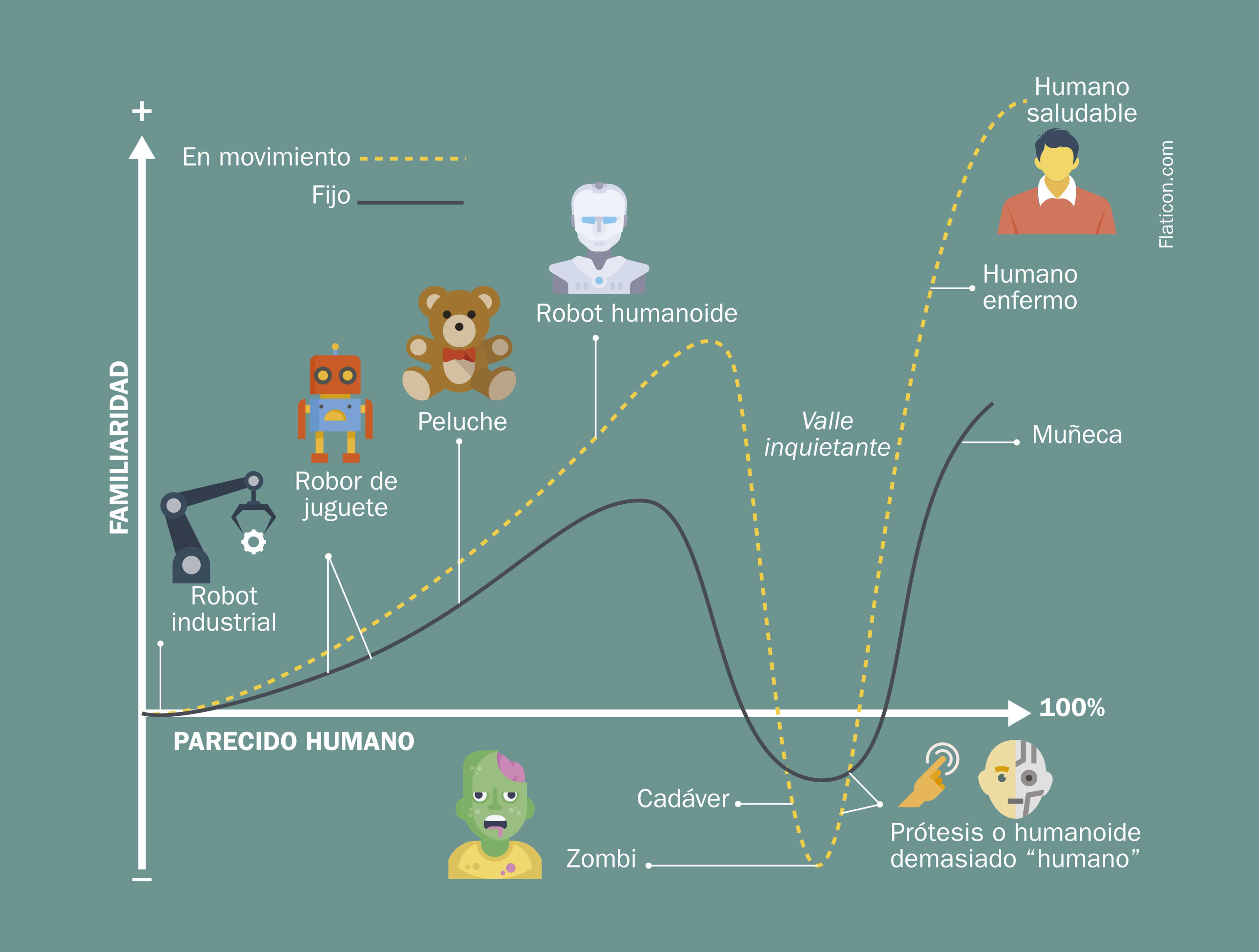

Máquinas antropomórficas: del amor al rechazo

En la década de 1970 el ingeniero japonés Masahiro Mori propuso la hipótesis de que cuando un robot se asemeja demasiado en forma y comportamiento a los seres humanos reales, en lugar de empatía produce rechazo. Mori planteó esta idea a través de una gráfica en la cual se aprecia que mientras más similar sea el androide a nosotros, más positiva será la reacción emocional que provoque; sin embargo, existe una zona en la cual esta respuesta se torna negativa. La zona de la gráfica en la que se ve la caída ha sido llamada uncanny valley (valle misterioso o inquietante), un concepto de psicología que Sigmund Freud utilizó en un ensayo en 1919 para referirse a aquello que resulta familiar y perturbador a la vez. Justamente en esta zona los robots con apariencia demasiado humana dejan de ser gratos y se vuelven atemorizantes, quizá por la grotesca asociación entre lo vivo y lo inerte que provocan entes como los zombies, dice el profesor Jesús Savage, de la Facultad de Ingeniería de la UNAM.

Algoritmos genéticos

Junto con sus alumnos del Laboratorio de BioRobótica en la Facultad de Ingeniería, Jesús Savage ha dado forma desde 2012 a Justina, un robot de servicio premiado en torneos internacionales que puede reconocer personas y gestos, ubicarse espacialmente, ejecutar tareas como respuesta a instrucciones e interactuar con las personas.

Savage recuerda que a medida que lo mejoraban y hacían más complejo, el robot se asemejaba cada vez más a un ser vivo. Por esta razón adoptaron el enfoque “de abajo hacia arriba” en la construcción de este tipo de robots, utilizando algoritmos genéticos inspirados en la evolución biológica que, como los organismos, son capaces de adaptarse y mutar ante las presiones de su medio ambiente. De la misma manera en que lo ha hecho la naturaleza desde hace miles de millones de años con los seres vivos, los expertos de la Facultad de Ingeniería realizan simulaciones computarizadas con las que ponen a prueba los algoritmos genéticos en ambientes virtuales.

Para ejemplificar cómo funcionan estos algoritmos genéticos, Savage evoca el trabajo de las hormigas para llevar alimento y mantener sus nidos. Hay grupos especializados para cada una de las tareas, pero la cooperación les permite sobrevivir a todas como una colonia. “Con los algoritmos genéticos tenemos una representación binaria de cada una de estas tareas especializadas” (explorar territorio, llevar alimento al nido, etc.), dice el investigador. Cada uno de ellos puede considerarse como un individuo, que luego se pone a prueba para resolver problemas específicos.

Vamos a suponer que en una población de 1 000 individuos (en este caso, 1 000 algoritmos) queremos seleccionar los más adecuados para dotar a un robot simulado de la capacidad de explorar. Tendremos que seleccionar aquellos que lo hayan puesto en movimiento y desechar a los que lo mantuvieron estático. Tras hacer la selección, probablemente tendremos 100 algoritmos en lugar de los 1 000 originales. Si ahora los combinamos entre sí de manera análoga a la reproducción biológica, induciremos modificaciones que darán como resultado una nueva población de 1 000 individuos que serán más aptos para la tarea especificada. “Si repetimos una y otra vez este proceso de seleccionar de los mejores, después de varias generaciones obtendremos individuos capaces de resolver el problema”, afirma Savage.

Autómatas de compañía

El rango de aplicaciones de los robots capaces de leer emociones es vasto y promisorio: desde guías automatizados en museos y galerías hasta asistentes personalizados en oficinas, hogares, asilos y hospitales.

Daniel Saldívar Navarro, del Centro Universitario de Ciencias Exactas e Ingenierías (CUCEI) de la Universidad de Guadalajara, ha construido con su equipo dos prototipos que buscan justamente ese objetivo. Los robots de los expertos del Departamento de Electrónica y Computación del CUCEI, llamados Marisol e Ismael, poseen programas de reconocimiento visual así como servomotores que les permiten seguir con la cabeza los movimientos de una persona. “Empezamos usando técnicas clásicas de visión artificial, pero ahora tenemos nuestros propios algoritmos, llamados metaheurísticos, que se enfocan en detectar formas geométricas básicas como círculos, líneas u óvalos mediante los cuales el robot puede identificar el rostro de una persona”, señala el investigador.

El especialista en inteligencia artificial del CUCEI, que obtuvo en 2009 la patente nacional de un robot modular ambulante, relata que el mayor reto para desarrollar estos prototipos no fue la programación, sino el ensamblaje de los componentes electromecánicos, que resolvieron gracias a la impresión en 3D (véase ¿Cómo ves? No. 203).

El grupo de Saldívar continúa mejorando este proyecto basado en el hardware libre (todos los diseños de las piezas están disponibles en internet) para que en el futuro sirvan a personas discapacitadas o de la tercera edad. “La idea es que estos robots no sólo analicen el significado textual de una frase o gesto, sino el contexto. Por ejemplo, al ver que una persona no ha comido o no se levanta de la cama, podrán inferir que no se siente bien y emitir un mensaje de alerta al médico de cabecera”.

Nuevos modelos

Hasta ahora, los expertos en inteligencia artificial han logrado que los robots comprendan y repliquen —al menos parcialmente— algunas de las expresiones emocionales que los humanos reconocemos universalmente: la alegría asociada con una sonrisa espontánea, el enojo de un ceño fruncido o la tristeza de un semblante desencajado. Pero, ¿podrán algún día superar a la ciencia ficción y construir replicantes dotados de sentimientos internos, capaces de enamorarse, condolerse ante el sufrimiento o alterarse por el llanto de un niño? Sossa Azuela se muestra escéptico: “Estamos muy lejos de que un robot experimente emociones de alto nivel como el amor”.

Sin embargo, acota, eso no quiere decir que no podrán reaccionar ante ciertos estímulos que a los humanos nos conmueven. Algunos proyectos de investigación como el Cajal Blue Brain (que pretende simular el funcionamiento de cerebros de mamíferos a nivel molecular) impulsarán el diseño de modelos neurológicos más avanzados que ayuden a tal fin. Por ejemplo, aunque no podemos expresar matemáticamente el miedo, sí podemos dotar a un robot con sensores y programas que lo hagan experimentar una sensación parecida al temor cuando esté a punto de agotarse su batería, dice el profesor Sossa. “Hay muchos problemas, sobre todo los de la vida real, que sólo se resuelven a través del aprendizaje. Así que tenemos que proponer nuevos modelos de redes neuronales que se aproximen más al funcionamiento de las neuronas humanas, que operan en forma colaborativa”, concluye.D

Más información

- Romero Herrera, Rodolfo, “Máquinas que piensan y sienten”, Revista Digital Universitaria, UNAM, 10 de marzo 2006, vol. 7, Núm. 3: www. revista.unam.mx

- Barceló Aspeitia, Axel Arturo, Juego doble: te quiero machine. Emociones de laboratorio y electrodomésticas, Instituto de Investigaciones Filosóficas, UNAM: www.filosoficas. unam.m

- BioRobotics UNAM: www.biorobotics. fi-p.unam.mx