Conciencia en la inteligencia artificial

Federico Bermúdez Rattoni, Daniel Osorio Gómez y Kioko Guzmán Ramos

Horst von Harbou, Metropolis. Wikimedia commons

¿Ciencia ficción o realidad?

Los sistemas de inteligencia artificial no sólo están transformando la ciencia y la industria, sino también la vida cotidiana. Se cree que incluso podrían llegar a ser capaces de soñar e imaginar. ¿Pero todo esto los haría seres conscientes?

Cuando era estudiante de secundaria Federico vio en el Cine Latino la película 2001: Odisea del espacio, de Stanley Kubrick. Lo que más le impactó fue la escena en la que la supercomputadora hal-9000 intenta tomar el control de la nave y expulsar al comandante Bowman. hal-9000 parecía haber adquirido conciencia, porque tomaba decisiones claramente encaminadas a protegerse a sí misma.

Esto no se ve en la película, pero según el guion, coescrito por Kubrick y el escritor de ciencia ficción Arthur C. Clarke, hal-9000 tenía muchas habilidades, como jugar ajedrez, producir y comprender el lenguaje humano, interpretar emociones e incluso apreciar el arte. Pero ¿equivale esto a tener conciencia?

Conciencia

Los sistemas de inteligencia artificial (ia) actuales, sobre todo los modelos de aprendizaje automático (machine learning en inglés), ya se utilizan en la industria, el gobierno, la ciencia y el entretenimiento. Estos sistemas aprenden de nuestras actividades en internet, siguen el contenido digital que consumimos, sugieren resultados en nuestras búsquedas, redirigen el tráfico en las ciudades, reconocen idiomas y rostros, pueden retarnos en un videojuego e incluso crean música, imágenes y novelas. Con cada avance la ia se vuelve más sofisticada, al grado de que hasta Geoffrey Hinton, pionero en esta tecnología y flamante ganador del premio Nobel de Física por su trabajo en aprendizaje automático, advierte que algunas ia podrían superar ciertas funciones cognitivas humanas. Esto incluye habilidades como el lenguaje, la sensación y la percepción, y funciones como la planeación o la toma de decisiones.

Los sistemas de ia tienen memorias cada vez más espaciosas que les permiten almacenar y procesar grandes cantidades de información. Esto podría permitir que adquieran capacidades más complejas, como soñar, imaginar y tener conocimiento tanto de sí mismos como del mundo que los rodea. Hay quienes incluso se preguntan si podrían experimentar emociones. Pero, ¿podría una ia llegar a desarrollar conciencia, como hal-9000? La respuesta dependerá de que entendamos qué significa tener conciencia, uno de los mayores desafíos en la neurociencia, la psicología y la filosofía.

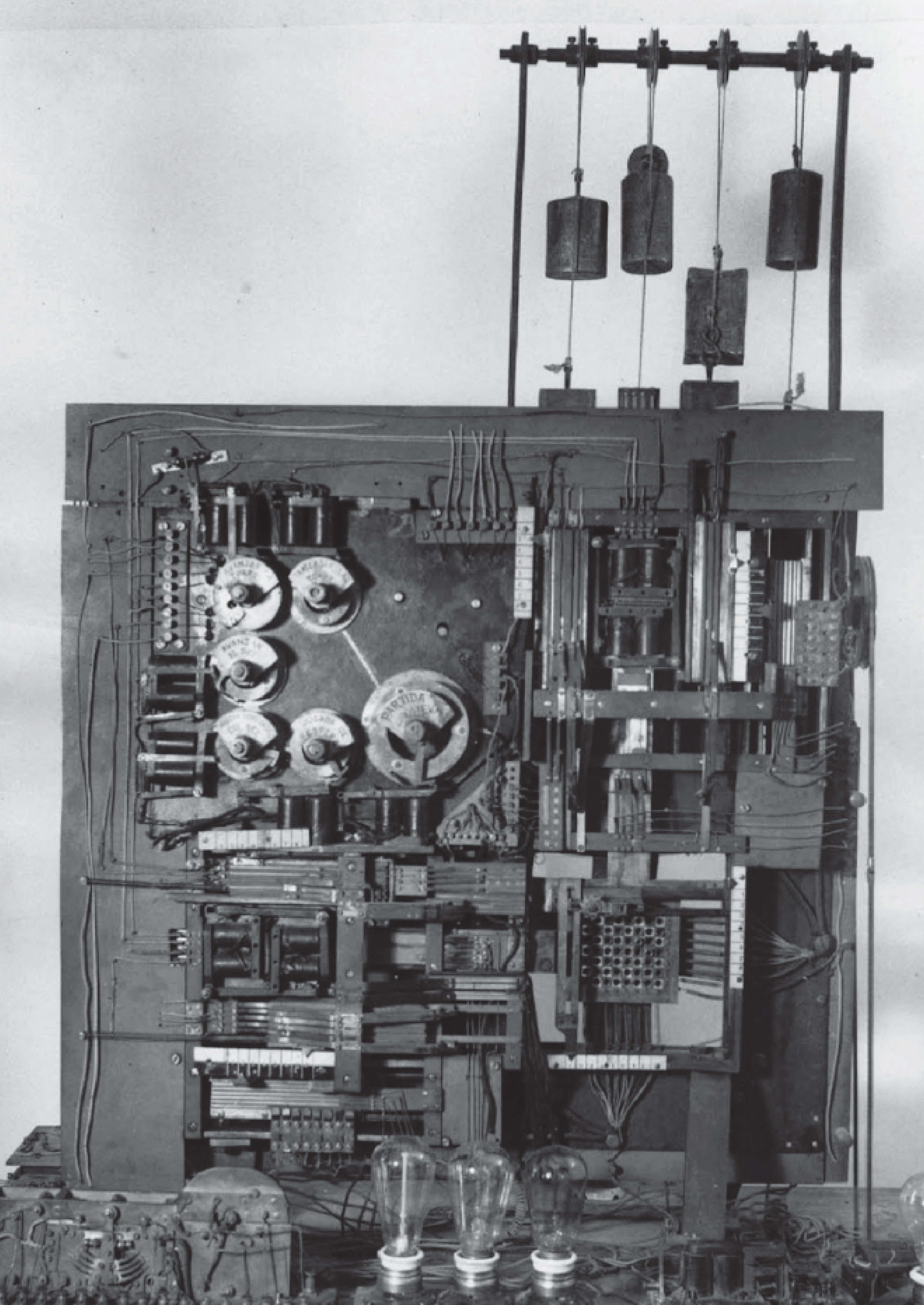

Foto: Shutterstock. Primer ajedrecista autómata, creado por Torres Quevedo 1910-1912

Foto: Shutterstock. Primer ajedrecista autómata, creado por Torres Quevedo 1910-1912

Prueba superada

Como reportó Celeste Biever en la revista Nature en 2023, ese año Chatgpt, el chatbot de la empresa Openai, superó cómodamente la prueba de Turing. Esta prueba fue propuesta por el científico Alan Turing en la década de 1950 para evaluar si una máquina puede hacerse pasar convincentemente por un ser humano en una conversación (escrita). Hoy hay muchos modelos avanzados de lenguaje que pueden pasar la prueba sin dificultad y, aunque los expertos se debaten sobre si esto equivale a la conciencia (hay científicos en ambos bandos), para poder determinarlo tendríamos que definir claramente qué es la conciencia y cómo medirla.

En una reunión celebrada en la Universidad de Cambridge en 2012 en la que participaron connotados científicos cognitivos, neurofarmacólogos, neurofisiólogos, neuroanatomistas y científicos computacionales se emitió la Declaración de Cambridge sobre la Conciencia. En esta declaración se afirma que distintas especies comparten circuitos cerebrales similares que participan en la sensación y la percepción de los estímulos que experimentamos. También se señala que el procesamiento de las emociones no se limita a las estructuras de la corteza cerebral (muy desarrollada en primates tanto humanos como no humanos), sino que otras estructuras más antiguas también participan en estas tareas en las personas y en otros animales. Esto sugiere que la conciencia puede surgir incluso en organismos sin neocorteza (la parte más reciente del cerebro de los mamíferos, que durante mucho tiempo creímos esencial para la conciencia humana).

Existe un intenso debate entre neurocientíficos, expertos en ia, filósofos y otros interesados en crear una definición de conciencia que pueda ser evaluada científicamente. Como ocurre con cualquier hipótesis científica, una definición debe probarse una y otra vez para ver qué tan bien se ajusta a la realidad.

Foto: Shutterstock

Foto: Shutterstock

Memoria

Muchas de las definiciones de conciencia que se han propuesto son contradictorias, vagas o demasiado complejas, y esto dificulta evaluarlas mediante experimentos. En medicina “conciencia” se refiere a un estado que puede dividirse entre estar consciente (despierto) o inconsciente (sin conciencia, pero no dormido), y se utiliza para evaluar el estado neurológico de los pacientes. Pero durante el sueño, especialmente en la fase de movimientos oculares rápidos (mor), experimentamos representaciones de vivencias que nos producen emociones que permanecen al despertar, como miedo, alegría, sorpresa o tristeza. Esto sugiere que un componente esencial de la conciencia surge a partir de lo vivido, de las experiencias, y no necesariamente de si estamos despiertos o dormidos. Pero hay enfoques diferentes; por ejemplo, el neurólogo portugués Antonio Damasio sostiene que la conciencia requiere emociones, y éstas se relacionan con la percepción de nuestro propio cuerpo y del entorno.

Un grupo de científicos de la Uni-versidad de Boston propuso recientemente que la conciencia podría estar estrechamente relacionada con los sistemas de memoria. La memoria no es un simple almacenamiento de la información que vamos recogiendo del ambiente. A partir de casos de pacientes humanos y de experimentos con animales sabemos que, en términos generales, es una función cognitiva que nos permite adquirir, integrar, recuperar, utilizar y actualizar la información de lo que experimentamos en el mundo a lo largo de nuestras vidas, aunque aún desconocemos cómo nos permiten las neuronas y sus sinapsis almacenar recuerdos.

Memorias de ayer y de hoy

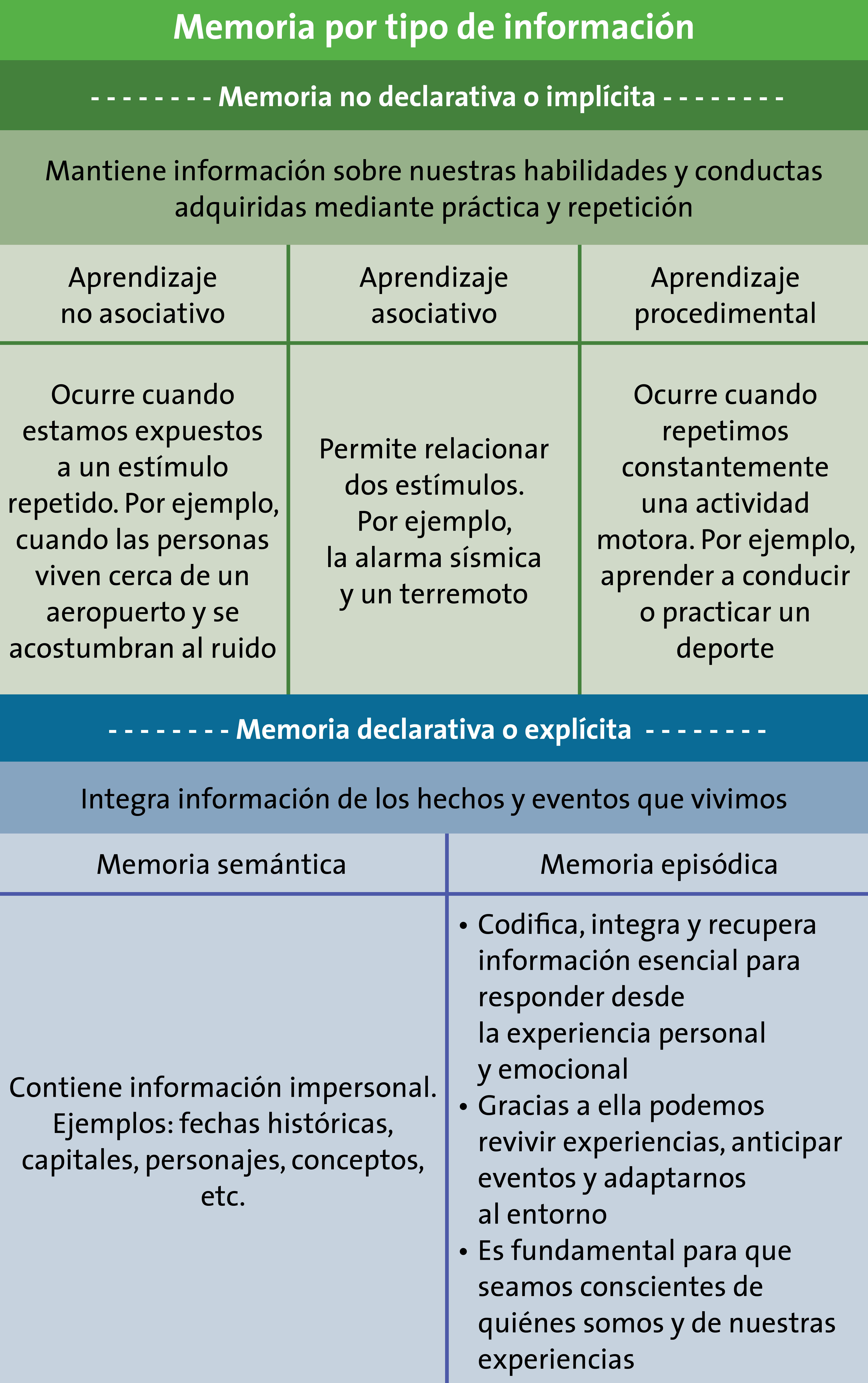

La memoria puede clasificarse de distintas formas. Por ejemplo, según el tipo de información que contiene se clasifica en declarativa y no declarativa. La memoria no declarativa guarda información de nuestras habilidades (como andar en bicicleta o tocar el piano) y las conductas que adquirimos mediante práctica y repetición. La memoria declarativa, por su lado, integra información de acontecimientos que vivimos. Los humanos podemos recordar y expresar el contenido de nuestra memoria declarativa de manera verbal. Se divide en dos tipos: semántica y episódica. La memoria semántica almacena conocimientos generales sobre el mundo que no están vinculados con experiencias personales ni con un contexto temporal o espacial específico: fechas históricas, capitales de países, personajes célebres y conceptos aprendidos en la escuela, o el nombre y las evoluciones de todos los Pokémon. Se trata de información impersonal, que no depende de acontecimientos vividos, sino de conocimientos quizá compartidos por muchas personas. La memoria episódica, en cambio, codifica información esencial para responder, desde la experiencia personal y emocional, preguntas como qué, cuándo y dónde con respecto a un acontecimiento vivido. La memoria episódica nos permite revivir experiencias pasadas y anticipar eventos futuros, y esto nos ayuda a tomar decisiones y a adaptarnos al entorno. Este tipo de memoria está relacionado con la actividad de una región del cerebro llamada lóbulo temporal medial, que está más o menos a la altura de la parte superior de las orejas.

Algunos pacientes con lesiones en esa región del cerebro pueden recordar información y realizar tareas complejas almacenadas en la memoria no declarativa. Ciertos pacientes pueden recordar experiencias personales, pero paradójicamente las relatan como si fuera información que leyeron en un libro, es decir, como si fuera información semántica (hechos) en lugar de experiencias vividas. Algo así pasa con personas que sufren la enfermedad de Alzheimer, que pueden recordar perfectamente la letra de una canción, por ejemplo, pero han perdido la capacidad de reconocer a seres queridos. Esto se debe a que en el Alzheimer la pérdida de memoria sigue un patrón progresivo: afecta primero la memoria episódica y luego la semántica. Este proceso ocurre porque las estructuras del hipocampo y las regiones del lóbulo temporal medial, responsables de la memoria episódica, son las primeras en deteriorarse. En cambio, las encargadas de la memoria semántica se ven afectadas en fases posteriores.

Éstos y otros casos sugieren que la memoria episódica es fundamental para que seamos conscientes de quiénes somos y de lo que hemos experimentado, así como para contrastar nuestro presente con el pasado y planear el futuro.

Aunque en algún momento se pensó que la memoria episódica era exclusiva de los humanos, hoy sabemos que tiene una historia evolutiva más antigua. Muchos animales muestran que pueden recordar experiencias pasadas de un modo muy parecido a nuestra memoria episódica, como recordar dónde y cuándo ocurrió algo y asociar emociones con lo que les sucede. Y además sabemos que usan estructuras equivalentes a las nuestras, como el hipocampo, que es fundamental en este tipo de memoria. Esto se refleja en comportamientos sorprendentes, como los de los elefantes, que recuerdan eventos asociados con sus cuidadores durante años o décadas. Se cree que la memoria episódica emergió cuando el cerebro comenzó a integrar información más compleja relacionada con qué ocurrió, dónde y cuándo. Esto fue posible gracias a la interacción del hipocampo con áreas superiores del cerebro, como las cortezas cerebrales, que procesan información elaborada. Si se agrega la integración de múltiples memorias episódicas y su expresión por medio del lenguaje queda claro que en los humanos la conciencia no evolucionó de forma separada al resto de nuestras capacidades cognitivas, sino como una combinación de muchas. La memoria episódica podría haber tenido un papel esencial.

Foto: Shutterstock

Foto: Shutterstock

La ia frente al espejo

Los algoritmos de aprendizaje profundo son capaces de procesar grandes volúmenes de información y resolver problemas complejos, pero carecen de memoria episódica porque no tienen cuerpo, noción del tiempo ni otras condiciones indispensables para vivir experiencias. Hasta cierto punto son como los pacientes con trastornos que afectan este tipo de memoria. Aunque la ia puede procesar múltiples tipos de información —por ejemplo datos sobre temperatura, compuestos químicos, señales eléctricas o texto— y responder a cambios en el entorno, nada indica que experimente el mundo de la misma manera que los organismos vivos. Por ejemplo, los edificios y hogares inteligentes tienen sensores que les dan información sobre el mundo y que, en combinación con algoritmos de ia, permiten ahorrar energía, pero no podemos decir que esta información equivalga a percibirlo como un ser consciente.

A diferencia de los sistemas artificiales, los seres humanos percibimos los estímulos del entorno y respondemos emocionalmente a lo que vivimos, y esto a su vez influye en cómo lo recordamos. Vivimos inmersos en un ambiente lleno de estímulos, pero sólo unos cuantos destacan; de otro modo habría demasiado ruido para poder fijar la atención en las cosas relevantes. La importancia que le da el cerebro a un estímulo está relacionada con la concentración de moléculas llamadas neuromoduladores, que amplifican nuestras respuestas. Por ejemplo, un evento estresante eleva los niveles de noradrenalina, mientras que una experiencia novedosa o gratificante incrementa los niveles de dopamina. Tales neuromoduladores facilitan que la información llegue a la memoria episódica. Esto ocurre sobre todo en una estructura del cerebro llamada sistema límbico, que regula las emociones y tiene un papel clave en la consolidación de los recuerdos en función de su impacto emocional.

Las experiencias integradas en nuestra memoria no sólo influyen en nuestra respuesta a los estímulos futuros, sino también en las emociones que asociamos con ellos. Por el momento la ia no tiene ningún equivalente a las emociones. Por más sofisticadas que sean sus respuestas, siguen siendo automatizadas y carentes de un componente emocional: una ia no puede estar contenta, enojada ni asustada ni asociar estos estados con la información que recibe. Nosotros sí.

Cuando los humanos sufrimos alteraciones en la memoria episódica podemos tener problemas de actualización de la autoidentidad, es decir, en la capacidad de reconocernos a lo largo del tiempo. Los seres humanos y otros mamíferos, como elefantes, delfines, chimpancés y gorilas, podemos reconocernos en un espejo, lo que demuestra una autoidentificación inmediata. Algunos robots han podido reconocerse en un espejo, pero lo hacen comparando patrones visuales con modelos que ya tienen sobre cómo se ven en diferentes posiciones en el espacio. Este reconocimiento no implica una verdadera autoidentidad como la que experimentamos los humanos.

A diferencia de los robots los humanos no sólo nos identificamos en el espejo, sino que también experimentamos emociones al vernos reflejados, lo que nos lleva a cuestionarnos qué sentimos, pensamos y somos. Estas reflexiones nacen de nuestra experiencia personal y de la información almacenada en la memoria episódica, que nos permite conectar el presente con el pasado para darle sentido a nuestra identidad.

En personas con alteraciones en la memoria episódica ocurre algo curioso: aunque pueden identificarse en el espejo creen que el espejo está mal porque no logran actualizar su autoimagen con el paso del tiempo. Es como si estuvieran atrapadas en un presente constante, sin notar los cambios en su apariencia y sin poder integrar estos cambios en su narrativa personal. Este tipo de alteraciones sugiere que la conciencia no se limita al presente, sino que depende de una narrativa continua que dé sentido a nuestra identidad y que evolucione con el tiempo. Si la autoidentidad no se actualiza mediante los recuerdos, la persona puede conservar habilidades como la atención, la memoria de trabajo, la percepción, el lenguaje e incluso una noción básica de quién es, pero su conciencia queda fragmentada. Pierde la capacidad de sentirse como un “yo” que cambia en el tiempo.

Así, la conciencia humana podría no ser estática, sino un proceso dinámico que depende de la memoria episódica y de nuestra capacidad de reconocer cambios personales a lo largo de la vida. Sin esa integración entre pasado y presente la experiencia consciente queda incompleta.

Foto: Shutterstock

Foto: Shutterstock

¿Personas artificiales?

Si estamos en lo correcto, la falta de memoria episódica significa que es improbable que una ia desarrolle una conciencia similar a la humana. La pregunta es si un algoritmo sin cuerpo, por más complejo que sea, puede desarrollar algún otro tipo de conciencia funcional. Creemos que, incluso en caso de que sí, sería una conciencia limitada, porque recuperar información guardada no es lo mismo que revivir experiencias desde una perspectiva personal. ¿Cómo podríamos saber si una ia desarrolla conciencia de cualquier tipo? Habría que crear nuevas herramientas inspiradas en la neurociencia cognitiva que midan si es capaz de procesar información contextual sobre el pasado y proyectarla hacia el futuro. Lo que es seguro es que mientras no haya evidencia de una memoria episódica en una ia, cualquier tipo de conciencia que desarrolle será diferente de la humana.

También hay que preguntarnos qué haríamos si descubriéramos que es posible dotar a una ia de memoria episódica. ¿Sería ético? Y si alguna vez desarrollara esta capacidad, lo que implicaría una forma de autoidentidad y narrativa personal, ¿podríamos apagarla o tendríamos que darle derechos, como ya se hizo al declarar a ciertas especies de primate personas no humanas? Y, finalmente, ¿quién debe decidir todo esto?

Hacia el final de 2001: Odisea del espacio Bowman desconecta los módulos de hal-9000, comenzando por los relacionados con su memoria, y observamos cómo se degrada progresivamente. Al final, la computadora queda reducida a repetir fragmentos de su información programada original, como la fecha de su activación, o a cantar de forma automática y sin emoción, como si su esencia se hubiese desvanecido. De alguna manera, ha perdido la conciencia.

Horst von Harbou - Metropolis. Wikimedia commons

Horst von Harbou - Metropolis. Wikimedia commons

- Miguel Benasayag y Ariel Pennisi, La inteligencia artificial no piensa (el cerebro tampoco), Buenos Aires, Prometeo, 2023.

- Markus Gabriel, “Inteligencia artificial: sus desafíos éticos”, Cátedra Alfonso Reyes, Tec de Monterrey, 19 de abril de 2023, en: https://www.youtube.com/live/53Fppop76_o?si=25QLbxgCyiMec3v_.

Federico Bermúdez Rattoni es investigador emérito de la unam y del Sistema Nacional de Investigadoras e Investigadores. Obtuvo el Premio Nacional de Ciencias. Está adscrito al Departamento de Neurociencia Cognitiva del Instituto de Fisiología Celular, unam.

Daniel Osorio Gómez es investigador del Departamento de Neurociencia Cognitiva del Instituto de Fisiología Celular de la unam y miembro del Sistema Nacional de Investigadoras e Investigadores.

Kioko Guzmán Ramos es profesora del Departamento de Ciencias de la Salud de la Universidad Autónoma Metropolitana Unidad Lerma y miembro del Sistema Nacional de Investigadoras e Investigadores.